按照本系列从头开始使用 Python 学习 CUDA 编程

介绍

GPU(图形处理单元),顾名思义,最初是为计算机图形学开发的。从那时起,它们几乎在每个需要高计算吞吐量的领域都无处不在。这一进步得益于 GPGPU(通用 GPU)接口的发展,这些接口使我们能够对 GPU 进行编程以进行通用计算。这些接口中最常见的是CUDA,其次是OpenCL,最近的是 HIP。

按照本系列从头开始使用 Python 学习 CUDA 编程

GPU(图形处理单元),顾名思义,最初是为计算机图形学开发的。从那时起,它们几乎在每个需要高计算吞吐量的领域都无处不在。这一进步得益于 GPGPU(通用 GPU)接口的发展,这些接口使我们能够对 GPU 进行编程以进行通用计算。这些接口中最常见的是CUDA,其次是OpenCL,最近的是 HIP。

您是否应该删除、插入或估算?

人工智能模型是否正在向现实的统一表征演进?柏拉图表征假说认为,人工智能模型正在趋同。

麻省理工学院最近的一篇论文引起了我的注意,因为它提出了一个令人印象深刻的观点:人工智能模型正在趋同,甚至跨越了不同的模态--视觉和语言。"我们认为,人工智能模型,尤其是深度网络中的表征正在趋同",这是 The Platonic Representation Hypothesis (https://arxiv.org/abs/2405.07987)论文的开头。

多年来,一种名为长短期记忆(LSTM)的神经网络一直是处理文本等序列数据的主要模型。LSTM 早在 20 世纪 90 年代就已问世,它善于记忆长程模式,避免了早期递归网络所面临的 "梯度消失" 技术问题。这使得 LSTM 在语言建模、文本生成、语音识别等所有语言任务中都具有难以置信的价值。在相当长的一段时间里,LSTM 看起来势不可挡。

将自然语言查询转化为代码是 NLP 领域最艰巨的挑战之一。将一个简单的英语问题转换成复杂代码的能力为开发人员的工作效率和快速软件开发生命周期提供了多种可能性。这就是开源大语言模型 Google Gemma 发挥作用的地方。本指南将探讨如何使用 unsloth 微调 Google Gemma,以便从自然语言查询生成代码语句。

如何在企业级同时实施知识图谱 (KG) 和大型语言模型 (LLM)

大型语言模型(LLM)和知识图谱(KG)是让更多人访问数据的不同方法。知识图谱使用语义学将数据集通过其含义(即它们所代表的实体)连接起来。LLM 使用向量和深度神经网络来预测自然语言。它们通常都以 "解锁 "数据为目标。对于实施 KGs 的企业来说,最终目标通常是建立数据市场、语义层、使数据 FAIR 化或使企业更加以数据为中心。这些都是不同的解决方案,但最终目标是相同的:让更多数据更快地提供给合适的人。对于实施 LLM 或其他类似 GenAI 解决方案的企业来说,其目标往往是相似的:为员工或客户提供一个 "数字助理",以便更快地将正确的信息提供给正确的人。这种潜在的共生关系是显而易见的:LLM 的一些主要弱点,即它们是黑盒模型,难以处理事实知识,而这正是 KG 的一些最大优势。从本质上讲,KG 是事实的集合,而且完全可以解释。但是,在企业中,KGs 和 LLMs 究竟应该如何结合使用呢?

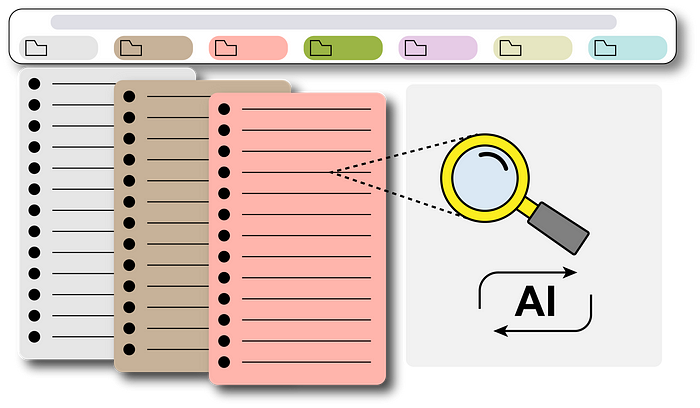

「基于 GPT 的书签自动搜索 pipeline 分步指南」

自用文,有需要的自取。

百度网盘同步会认为移动硬盘是系统盘,所以无法进行同步。当然,也有例外的,之前我也是不知怎么同步的。

这次设置的时候被警告了,不允许设置。

仅个人需求,有需要的可以自取。

前段时间为家里孩子下载了一批课程,但是文件命名就很奇怪也很乱,就想着将文件名修改掉便于查看。