什么是负责任的人工智能

拥有权利的同时也被赋予了重大的责任

对于某些人来说,“人工智能”一词可以激发人们对进步和生产力的思考。但对于其他人来说,前景并不乐观。许多担忧都是合理的,例如不公平的决策、工人被取代以及缺乏隐私和安全。更糟糕的是,许多这些问题都是人工智能所独有的。这意味着现有的指导方针和法律不适合解决这些问题。这就是负责任的人工智能的用武之地。它旨在解决这些问题并为人工智能系统建立问责制。

为什么我们需要负责任的人工智能

当我们谈论人工智能时,我们通常指的是系统内用于自动化某些事情的机器学习模型。例如,自动驾驶汽车可以从传感器拍摄图像。机器学习模型可以使用这些图像进行预测(例如,我们面前的物体是一棵树)。汽车会根据这些预测做出决策(例如,左转以避开树木)。我们将整个系统称为人工智能。

这只是一个例子。人工智能可以用于从保险承保到癌症检测等任何领域。其决定性特征是系统做出的决策几乎没有人为干预。这可能导致许多潜在问题,公司需要定义使用人工智能的明确方法。负责任的人工智能是一个治理框架,旨在实现这一点。

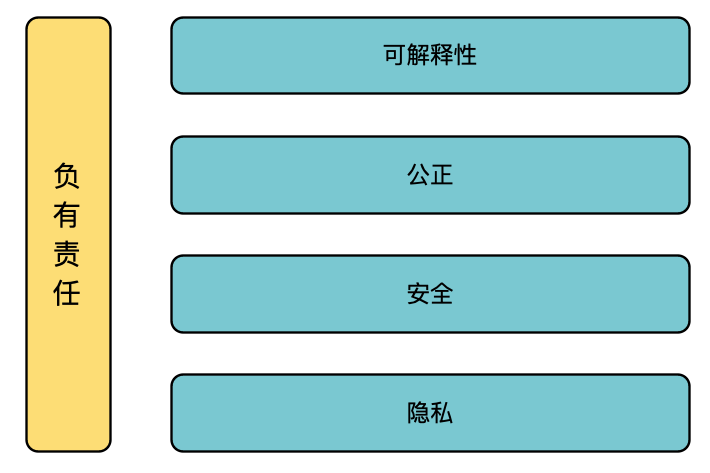

该框架可以包括有关可以收集和使用哪些数据、如何评估模型以及如何最好地部署和监控模型的详细信息。该框架还可以定义谁对人工智能的任何负面结果负责。不同公司的框架会有所不同。有些会定义具体的方法,而另一些则更容易被解释。他们都在寻求实现同一件事。那就是创建可解释、公平、安全且尊重用户隐私的人工智能系统。

负责任的人工智能的目标

提到的第一个领域是可解释性。当我们解释一个模型时,我们会得到它如何进行预测的解释。人工智能系统可能会拒绝你的抵押贷款申请或诊断你患有癌症。即使这些决定是正确的,用户也可能会要求解释。有些模型比其他模型更容易解释,这使得获得解释更容易。负责任的人工智能可以定义我们如何构建可解释的模型,或者何时可以使用不太可解释的模型。

与可解释性相关的是模型公平性 。人工智能系统可能会做出歧视某些人群的决策。这种偏见来自用于训练模型的数据中的偏见。一般来说,模型的可解释性越高,就越容易确保公平性并纠正任何偏见。我们仍然需要一个负责任的人工智能框架来定义我们如何评估公平性,以及当发现模型做出不公平的预测时该怎么做。这在使用可解释性较差的模型时尤其重要。

安全和保障是另一个令人担忧的问题。这些问题对软件开发来说并不新鲜,可以通过加密和软件测试等技术来解决。不同之处在于,与一般的计算机系统不同,人工智能系统不是确定性的。当面对新的场景时,它们可能会做出意想不到的决定。系统甚至可以被操纵做出错误的决定。当我们与机器人打交道时,这一点尤其令人担忧。如果它们犯了错误,自动驾驶汽车等可能会造成伤亡。

最后一个方面是隐私和数据治理。所用数据的质量很重要。如果人工智能使用的数据有误,那么系统可能会做出错误的决定。一般来说,人工智能也不应该被允许使用敏感数据(例如病史、工会会员资格)。在欧洲,许多这些问题都由[GDPR]1解决。在欧洲以外,这些问题需要由公司自己的负责任的人工智能框架来解决。

归根结底,这一切都归结为信任。如果用户不信任人工智能,他们就不会使用你的服务。我们不会信任那些使用我们不愿意分享的信息或我们认为它会做出有偏见决定的系统。如果我们认为它会对我们造成身体伤害,我们当然不会信任它。对决策的解释和对这些决策的责任对于建立这种信任大有裨益。这种对信任的需求正是推动使用人工智能的公司自我监管的动力。

负责任的人工智能的未来

目前,在人工智能方面,企业需要自我监管。这意味着他们必须制定并实施自己的负责任人工智能准则。谷歌、微软和 IBM 等公司都有自己的准则。但问题在于,负责任人工智能的原则在不同行业中的应用可能不一致。规模较小的公司甚至可能没有资源来制定自己的准则。

一个潜在的解决方案是让所有公司采用相同的准则。例如,欧盟委员会最近发布了《值得信赖的人工智能道德准则》。该准则详细说明了人工智能应具备的 7 个关键要求,才能被视为值得信赖。使用这些准则将有助于公司确保其人工智能系统符合相同的标准。真正的问题是——我们能相信公司会自我监管吗?

人工智能和机器学习现状报告涵盖了 374 家从事数据/人工智能工作的组织的回复。75% 的组织表示人工智能是其业务的关键部分。然而,只有 25% 的组织表示公平的人工智能很重要。这表明答案是否定的;不,我们不能相信它们。要使通用准则有效,还必须执行它们。换句话说,准则必须成为法律/法规,不遵守准则的公司必须面临处罚。

“我毫不怀疑人工智能需要受到监管。问题是如何最好地解决这个问题,”—— Sundar Pichai(谷歌首席执行官)

这似乎确实是我们前进的方向。欧洲提出过相关法规。它们基于上述道德准则,将影响许多行业。目前,美国还没有这样的法规。不过,谷歌、Facebook、微软和苹果等科技公司的高管都呼吁对数据和人工智能进行更多监管。所以这似乎只是时间问题。

我们提到了算法公平性。它是负责任的人工智能的重要组成部分,很可能成为许多人工智能监管的重点。这本身就是一个非常有趣的话题,我们在[什么是算法公平性]文章中有过更深入地探讨。

负责任的 AI 框架示例

其他参考

D. Pessach & E. Shmueli, Algorithmic Fairness (2020), https://arxiv.org/abs/2001.09784

A. Gillis, responsible AI (2021), https://searchenterpriseai.techtarget.com/definition/responsible-AI

Accenture, Responsible AI: A Framework for Building Trust in your AI Solutions (2018), https://www.accenture.com/_acnmedia/PDF-92/Accenture-AFS-Responsible-AI.pdf

Appen, The 2020 State of AI and Machine Learning Report (2020), https://appen.com/whitepapers/the-state-of-ai-and-machine-learning-report/

K. Walch, AI Laws Are Coming (2020), https://www.forbes.com/sites/cognitiveworld/2020/02/20/ai-laws-are-coming/?sh=5b526ef7a2b4

S. Schechner & V. Pop, Google Pushes ‘Sensible’ Ideas for How to Regulate AI (2020), https://www.wsj.com/articles/google-pushes-sensible-ideas-for-how-to-regulate-ai-11579521003?mod=article_inline

A. Satariano, Europe Proposes Strict Rules for Artificial Intelligence (2021), https://www.nytimes.com/2021/04/16/business/artificial-intelligence-regulation.html?smtyp=cur&smid=tw-nytimes

「AI秘籍」系列课程:

GDPR: https://gdpr.eu/↩︎

谷歌: https://ai.google/responsibilities/responsible-ai-practices/↩︎

微软: https://www.microsoft.com/en-us/ai/responsible-ai?activetab=pivot1%3Aprimaryr6↩︎

IBM: https://www.ibm.com/artificial-intelligence/ethics↩︎

欧盟委员会: https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai↩︎

什么是负责任的人工智能